Co to jest i jak działa Deepfake?

W ciągu ostatnich kilku dekad nastąpił gwałtowny rozwój technologii sztucznej inteligencji. Znajduje ona zastosowanie w różnych dziedzinach i służy niezliczonym celom. Poprawia jakość i wydajność wielu branż. Jednak nie wszystkie produkty AI mają pozytywny wpływ na społeczeństwo. Czasami tworzone są technologie, które są później nadużywane przez przestępców. Świetnym przykładem może być chociażby deepfake.

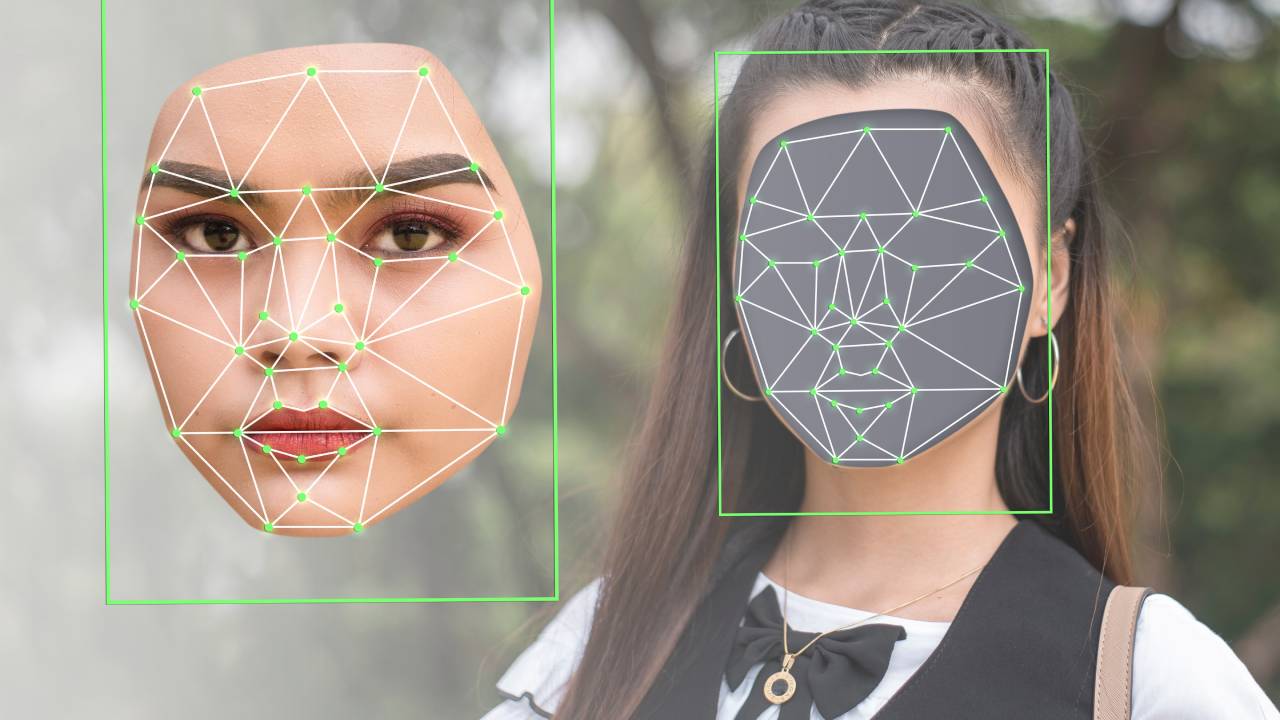

Programy oparte na sztucznej inteligencji są szkolone do zastępowania twarzy danej osoby twarzą innej osoby, zarówno na zdjęciu, jak i na nagraniu wideo. Ofiarami takich działań są bardzo często znane osoby, celebryci i politycy. W tym artykule wyjaśnimy, na czym polega technologia deepfake, w jaki sposób jest wykorzystywana i jak można ją wykryć.

Spis treści:

Co to jest deepfake?

Słowo “deepfake” jest dość oczywistym połączeniem dwóch używanych na co dzień słów: “deep” i “fake”. Deep odnosi się tutaj do technologii sztucznej inteligencji, która jest znana jako deep learning. Technologia deepfake jest wykorzystywana w syntetycznych mediach do tworzenia fałszywych treści, zastępowania lub syntetyzowania twarzy, mowy i manipulowania emocjami.

Służy ona do cyfrowego imitowania działań danej osoby, których ta nie wykonała. Pierwsze kroki w kierunku tej technologii zostały podjęte w latach 90. przez instytucje akademickie, a następnie zostały zaadaptowane przez szerszą publiczność. Mimo że tworzenie programów typu deepfake nie należy do głównego nurtu, koncepcja ta zdążyła już narobić sporo szumu w przestrzeni medialnej. W następnej sekcji wyjaśnimy, w jaki sposób powstają treści deepfake.

Jak działa deepfake?

Istnieje kilka technik tworzenia oprogramowania deepfake wykorzystujących algorytmy uczenia maszynowego. Mówiąc najprościej, są to algorytmy, które potrafią generować treści na podstawie wprowadzonych danych. Jeżeli przed programem postawiono zadanie stworzenia nowej twarzy lub zastąpienia części twarzy danej osoby, musi on najpierw przejść szkolenie. Program otrzymuje ogromną ilość danych, które następnie wykorzystuje do nauki tworzenia własnych, nowych informacji. W większości przypadków bazują one na autoenkoderach, a czasem na generatywnych sieciach przeciwstawnych (GAN). Sprawdźmy teraz, czym są te metody i jak działają.

Autoenkodery

Autoenkodery to rodzina samouczących się sieci neuronowych, opartych głównie na redukcji wymiarowości, które uczą się kopiować swoje dane wejściowe. Są one specyficzne dla danych, co oznacza, że mogą kompresować dane podobne do tych, na których zostały wytrenowane.

Poza tym dane wyjściowe autoenkodera nie będą identyczne z danymi wejściowymi. Autokoder składa się z trzech elementów: kodera, kodu i dekodera.

Koder kompresuje dane wejściowe i tworzy kod, po czym dekoder rekonstruuje dane wejściowe tylko na podstawie kodu. Istnieją różne typy autoenkoderów: autoenkodery denoisingowe, autoenkodery głębokie, autoenkodery kurczliwe, autoenkodery konwolucyjne itd.

Generatywne sieci przeciwstawne (Gan)

Generatywna sieć przeciwstawna (Gan) to podejście do modelowania generatywnego na podstawie zbioru danych wejściowych. Uczą się one na podstawie danych wejściowych, aby generować nowe dane. System jest trenowany przez dwie odrębne sieci neuronowe: generator i dyskryminator.

Generator odkrywa prawidłowości lub wzorce w zbiorze danych wejściowych i uczy się je odtwarzać. Wygenerowane dane są przesyłane do dyskryminatora wraz z danymi rzeczywistymi w celu ich oceny. Zadaniem generatora jest oszukiwanie dyskryminatora. System należy trenować tak długo, aż dyskryminator przestanie mylić wygenerowane dane z danymi rzeczywistymi.

Im trudniej jest odróżnić wygenerowane dane od danych rzeczywistych, tym lepiej system jest wytrenowany. GAN-y są trudniejsze do wytrenowania i wymagają więcej zasobów. Są one częściej wykorzystywane do generowania zdjęć niż wideo.

Czy deepfake są niebezpieczne?

Deepfake jest uważany za jedno z najniebezpieczniejszych zastosowań sztucznej inteligencji. Większość jego realnych przypadków użycia ma charakter dyskredytujący lub związany z oszustwem. Jeden z pierwszych przypadków oszustwa z wykorzystaniem deepfake miał miejsce w Wielkiej Brytanii. Oszuści zadzwonili do dyrektora generalnego brytyjskiej firmy energetycznej i podszywając się pod jego niemieckiego szefa, nakazali mu przelać 220 000 euro na konto bankowe innej firmy.

Końcowy rezultat działania deepfake może być nieodróżnialny od rzeczywistości. Może on zaszkodzić reputacji danej osoby lub doprowadzić do tego, że powie ona lub zrobi coś zupełnie niepotrzebnego. Jest to doskonała broń w rękach oszustów. Stworzenie systemu, który rozpoznaje deepfake, wymaga bowiem dużego nakładu czasu i pracy (przeszkolenia).

Jak deepfake wpływa na nasze społeczeństwo?

Dostanie się w niepowołane ręce deepfake może prowadzić do chaosu i niepewności. W 2018 r. na WhatsApp przesłano wideo, na którym dwóch mężczyzn na motocyklu porywa dziecko w Indiach. Po opublikowaniu tego nagrania wśród ludności wybuchła masowa panika, w wyniku której zginęło kilka osób.

Nasze społeczeństwo jest zbudowane na autorytecie liderów, gwiazd i influencerów. Dezinformacja z ich udziałem również może zmienić nastrój wśród mas i zachęcić do podjęcia różnych działań. Takie rzeczy miały już miejsce. W Internecie wielokrotnie pojawiały się np. fałszywe filmy porno z udziałem celebrytów.

W temat ten zaangażowanych było nawet kilku prezydentów USA. Fake newsy dotyczące przywódców politycznych mogą podważyć reputację rządzących krajem i doprowadzić do utraty ich wiarygodności.

Czy deepfake jest legalny?

Ponieważ deepfake zaczął się rozprzestrzeniać dopiero w ostatnich kilku latach, prawo dotyczące jego stosowania nie nadąża za tą technologią. W wielu krajach nie jest ona w ogóle uregulowana.

Jednym z państw, w których istnieje prawo dotyczące stosowania deepfake, są Chiny. Chińska Administracja Cyberprzestrzeni ogłosiła, że fake newsy tworzone przy użyciu deepfake są nielegalne.

W Stanach Zjednoczonych prawie wszystkie stany mają przepisy dotyczące deepfake porno. Inny projekt ustawy zakazuje stosowania treści deepfake, które dotyczą kandydatów ubiegających się o urzędy publiczne.

Z kolei Komisja Europejska wezwała firmy big tech do opracowania narzędzi służących do weryfikacji informacji i nawiązania współpracy z organizacjami zajmującymi się sprawdzaniem faktów.

Jak wykorzystywane są deepfake? – Przykłady

Rozprzestrzenianie się zjawiska deepfake rozpoczęło się od fałszywych filmów porno. Ofiarą deepfake porn padło wiele celebrytek. Wśród nich były Daisy Ridley, Jennifer Lawrence, Emma Watson i Gal Gadot. Temat ten dotyczył również kobiet związanych z przywódcami różnych krajów, takich jak Michelle Obama, Ivanka Trump i Kate Middleton. W 2019 r. pojawiła się aplikacja desktopowa o nazwie DeepNude. Umożliwiała ona usuwanie odzieży z kobiet. Jakiś czas później została ona usunięta, ale nadal można znaleźć jej kopie krążące w Internecie.

Kolejną grupą osób poszkodowanych przez deepfake są politycy. W sieci pojawiły się nagrania wideo, na których np. prezydent Obama obraża prezydenta Trumpa. Na innym filmie przemówienie Nancy Pelosi zostało przetworzone tak, aby publiczność uwierzyła, że jest ona pijana. W jeszcze innym nagraniu wideo pokazano, jak prezydent Trump kpi z Belgii za jej członkostwo w paryskim porozumieniu klimatycznym.

Oczywiście wraz z rozwojem branży, deepfake zaczęto wykorzystywać także w przypadku kryptowalut. O takich przypadkach informowaliśmy nawet na łamach naszego portalu. Przykładowo pod koniec maja oszuści wykorzystali deepfake z Elonem Muskiem i innymi prominentnymi zwolennikami kryptowalut do promowania scamu BitVex.

Należy jednak zauważyć, że istnieją również przypadki legalnego wykorzystania deepfake’ów. W App Store i Play Market można znaleźć wiele aplikacji do podmieniania twarzy na zdjęciach i filmach. Generalnie istnieje opinia, że deepfake to przyszłość tworzenia treści. Południowokoreański kanał MBN wykorzystał na przykład deepfake do zastąpienia swojego prezentera wiadomości.

Szantaż

Deepfake to bardzo groźne narzędzie w rękach szantażystów. Nasze społeczeństwo, zwłaszcza starsze pokolenie, nie jest jeszcze w pełni świadome istnienia technologii, która może zastąpić twarz w filmie wideo.

Raffaela Spone z Pensylwanii udostępniła fałszywe nagrania wideo, na których widać nagie, pijane i palące członkinie grupy cheerleaderek. Wszystko po to, aby wyeliminować z konkursu rywalki swojej córki. Na szczęście rodziny ofiar skontaktowały się z policją, a jej plan został udaremniony.

Polityka

Jak już wspomnieliśmy wcześniej, politycy należą do osób, które najczęściej stają się obiektem fałszywych filmów wideo. Kompromitujące nagrania z udziałem kandydatów w wyborach mogą poważnie zaszkodzić ich wiarygodności.

W 2019 r. artyści medialni Francesca Panetta i Halsey Burgund z MIT stworzyli deepfake’owe wideo, w którym wystąpił były prezydent USA Richard Nixon. W filmie tym Nixon ogłosił niepowodzenie programu Apollo 11, stwierdzając, że nikt z załogi nie powrócił z Księżyca.

Było to prawdziwe przemówienie przygotowane na potrzeby takiego scenariusza. Prace nad nagraniem trwały sześć miesięcy i prowadzone były przez grupę różnych specjalistów. Celem było stworzenie materiału jak najbardziej zbliżonego do rzeczywistego, aby pokazać potencjał technologii deepfake.

Na ich stronie internetowej znajdują się interaktywne zasoby edukacyjne, które pomogą użytkownikom zrozumieć, czym jest deepfake i jak go rozpoznać.

Sztuka

Jednym z popularnych zastosowań deepfake w sztuce jest tworzenie filmów ze słynnych portretów. Rosyjscy badacze zrobili to z Mona Lisą Da Vinciego. Muzeum Dali na Florydzie odtworzyło obraz na podstawie archiwalnych nagrań wideo, aby przyciągnąć zwiedzających.

Aktorstwo

W filmach dość często zachodzi konieczność charakteryzacji lub zmiany twarzy aktorów. W produkcji “Rogue One: A Star Wars Story” użyto deepfake do odtworzenia twarzy księżniczki Lei i Wielkiego Moffa Tarkina.

Filmy

Disney Research Studios pracuje nad własną technologią efektów wizualnych deepfake. Pozwoli ona znacznie skrócić czas i zmniejszyć koszty finansowe związane z uzyskaniem wizerunku pożądanej osoby. Problem polega na tym, że daje ona wysoką jakość tylko w niskich rozdzielczościach. Uzyskanie zadowalającego rezultatu o wysokiej jakości wymaga znacznie większego wysiłku. Jest to ta sama technologia, która została wykorzystana we wspomnianym wyżej filmie Star Wars.

Social media

Podczas gdy niektóre serwisy społecznościowe, takie jak Facebook czy Twitter, walczą z deepfake’ami i zakazują stosowania syntetycznych mediów poprzez aktualizację swoich zasad, inne je wykorzystują. Snapchat posiada funkcję kamery zamieniającej twarze od 2016 r. Podobną technologię wykorzystuje również TikTok.

Podszywanie się

We wcześniejszej części artykułu wspomnieliśmy o tym, jak południowokoreański kanał telewizyjny wykorzystał deepfake do zastąpienia swojego prezentera wiadomości. Technologia ta była też wykorzystywana do tych samych celów, ale z całkowicie wygenerowaną postacią.

Jedną z takich osób był Oliver Taylor, student Uniwersytetu w Birmingham. Z jego profili w mediach społecznościowych wynikało, że dorastał w żydowskiej rodzinie i był aktywnie zaangażowany w walkę z antysemityzmem.

Zwrócił on na siebie uwagę londyńskiego naukowca Mazena Masriego. Taylor oskarżył Masriego i jego żonę o sympatyzowanie z terrorystami. Nie ustalono, kto stał za tym profilem, ponieważ w sieci nie dało się pozyskać wystarczających informacji.

Warto wspomnieć tutaj również o deepfake’u, który zdobył sporą popularność na TikToku:

W 2017 r. grupa naukowców i przedsiębiorców założyła firmę Synthesia, oprogramowanie napędzane sztuczną inteligencją, zdolne do tworzenia treści audiowizualnych dla mediów syntetycznych. Umożliwia ono klientom tworzenie realistycznych filmów z fikcyjnymi postaciami.

Jak wykryć deepfake?

Technologie, które rozpoznają deepfake, są również oparte na sztucznej inteligencji i wykorzystują algorytmy podobne do tych, które są używane do tworzenia samych deepfake’ów. Wykrywają one ślady, które nie znalazłyby się na prawdziwych zdjęciach lub filmach. Początkowo dobrym znakiem rozpoznawczym deepfake’u było nietypowe mrugnięcie oczu lub ich całkowity brak. Z czasem jednak systemy nauczyły się udawać mruganie oczami. Oznaki, które mogą świadczyć o tym, że mamy do czynienia z deepfake to:

- Nierealny kolor skóry lub zmiany w odcieniu skóry,

- Gwałtowne ruchy,

- Słaba synchronizacja mowy z ruchem warg,

- Twarze lub sylwetki osób, które są bardziej rozmyte niż tło,

- Zaburzenia oświetlenia,

- Dodatkowe piksele w kadrze.

W jaki sposób walczy się z deepfake?

Kilka wiodących firm technologicznych opracowuje już własne rozwiązania do walki z deepfake’ami. Microsoft i Google udostępniają zbiory danych, na podstawie których programiści mogą trenować swoje systemy wykrywania takich treści.

Facebook we współpracy z Microsoft, Amazon Web Services i czołowymi uniwersytetami z całego świata ogłosił konkurs Deepfake Detection Challenge. Jego celem było opracowanie rozwiązań do wykrywania deepfakeów. Zwycięzca konkursu otrzymał 500 000 USD.

Materiały do pracy, w której wzięło udział około 3500 aktorów, zostały udostępnione na zasadach open source, dzięki czemu mogą z nich korzystać inni badacze.

W ramach projektu MediFor DARPA podpisała umowy z SRI International na stworzenie programów, które będą w stanie wyszukiwać zmienione zdjęcia i filmy.

Sensiti oferuje własne rozwiązanie dla firm, które chcą się chronić przed technologiami deepfake.

Minerva to system, który wyszukuje porno deepfake w popularnych serwisach pornograficznych i automatycznie wysyła powiadomienie o konieczności usunięcia tych treści.

Warto zobaczyć również poniższy film z “Morganem Freemanem”, który przestrzega przed deep fake w bardzo efektowny sposób:

Czy biometria może pomóc w walce z deepfake?

Biometria to fizyczne cechy naszego ciała. Znajomość danych biometrycznych człowieka pozwala nam na jego identyfikację. Kluczem do wykorzystania biometrii w wykrywaniu fałszywych treści może być biometria behawioralna i inna technologia oparta na sztucznej inteligencji: rozpoznawanie twarzy.

Podsumowanie

Deepfake to bardzo młoda i obiecująca technologia. Ludzkość dopiero się z nią zapoznaje i nie znalazła jeszcze pełnego zastosowania w naszym społeczeństwie. Jak wiele technologii, ma ona swoje wady i zalety. Może zaszkodzić lub poprawić nasz świat.

Będziemy potrzebowali czasu, aby zrozumieć, jak w pełni wykorzystać ją w różnych branżach. Z czasem pojawi się wiele sposobów na kontrolowanie jej, podobnie jak w przypadku innych innowacji w przeszłości.

Aktualnie brak komentarzy.