Czy AI nam zagraża? Jak oszukuje sztuczna inteligencja

Sztuczna inteligencja (z ang. artifical intelligence, w skrócie AI) to koncepcja, której celem jest przełożenie sposobu, w jaki działa ludzki mózg do komputera, pozwalając maszynom, uczyć się, rozwijać oraz komunikować w naturalny dla nas sposób.

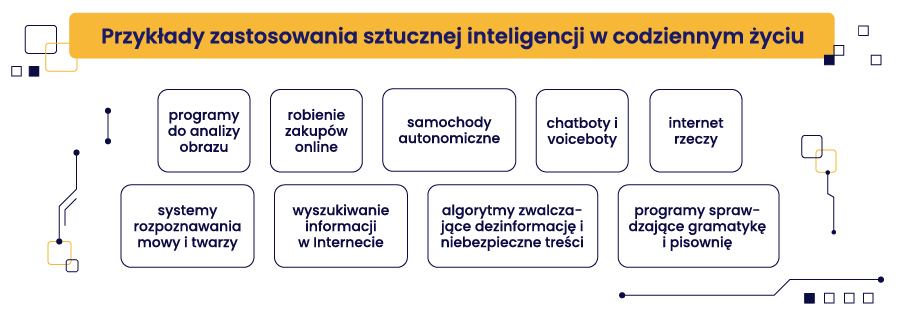

Chociaż nie zdajemy sobie z tego sprawy, to AI już od dawna jest obecna w wielu aspektach naszego życia codziennego, od prostych aplikacji, takich jak Google Assistant czy Siri, po zaawansowane systemy napędzające samochody autonomiczne i rakiety wystrzeliwane w kosmos. AI ma ogromny potencjał do poprawy jakości życia ludzi poprzez zwiększenie wydajności, bezpieczeństwa czy dostępu do informacji.

Jednak rozwój AI niesie ze sobą także pewne ryzyko i wyzwania związane z bezpieczeństwem i etyką. Szereg ekspertów, od tych z dziedzin technicznych aż po filozofię, ostrzega, że sztuczna inteligencja może stanowić zagrożenie dla ludzkości, jeśli nie będzie odpowiednio kontrolowana i regulowana.

W tym artykule przyjrzymy się bliżej potencjalnym zagrożeniom związanym ze sztuczną inteligencją (SI), sposobom, w jakie może nas oszukiwać, oraz możliwościom odpowiedzialnego rozwoju i regulacji. Zastanowimy się także nad przyszłością AI i ludzkości oraz nad tym, jak zachować równowagę między postępem technologicznym a ochroną naszych wartości i interesów.

Spis treści:

Co musisz wiedzieć o sztucznej inteligencji?

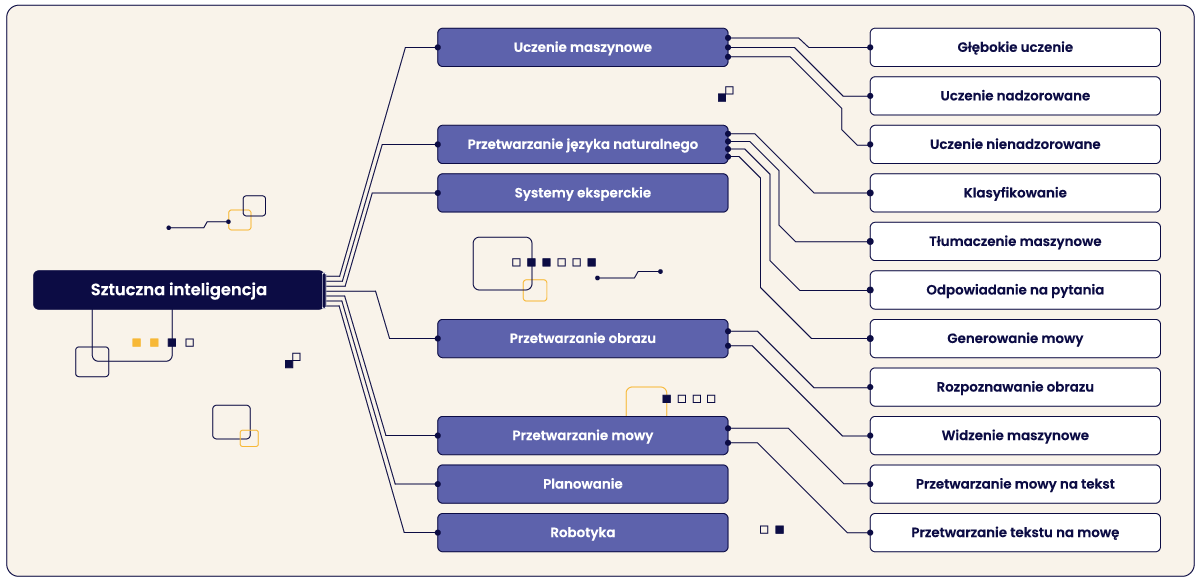

Sztuczna inteligencja odnosi się do systemów komputerowych zaprojektowanych do wykonywania zadań, które zazwyczaj wymagają ludzkiej inteligencji, takich jak percepcja wzrokowa, rozpoznawanie mowy, podejmowanie decyzji i tłumaczenie obcego języka. Celem AI jest stworzenie inteligentnych maszyn, które mogą naśladować ludzkie zdolności poznawcze.

Jej historia sięga wczesnych lat pięćdziesiątych XX wieku, kiedy to po raz pierwszy ukuto termin „sztuczna inteligencja”. Kluczowe okresy jej rozwoju obejmują:

- Lata 1950: Dziedzina badań nad sztuczną inteligencją została formalnie uchwalona na konferencji w Dartmouth w 1956 roku. Wczesne prace koncentrowały się na rozwiązywaniu problemów matematycznych i graniu w gry, takie jak szachy.

- Lata 1960: Wokół AI panował wielki optymizm i szum. Nastąpił boom badawczy i osiągnięto pierwsze sukcesy w takich dziedzinach, jak gry i przetwarzanie języka naturalnego. Wzrosło finansowanie rządowe,

- Lata 1970-1980: Pojawiło się rozczarowanie, gdy trudności w osiągnięciu inteligencji na poziomie ludzkim stały się oczywiste. Finansowanie spadło, a postęp był niewielki. Tak zwana „zima AI” trwała do późnych lat 80-tych,

- Lata 1980: Systemy eksperckie, które naśladowały ludzką wiedzę w wąskich obszarach problemowych, przyniosły pewien sukces i ożywiły zainteresowanie i finansowanie,

- Lata 1990-2000: Techniki sztucznej inteligencji dojrzewały wraz z postępami w uczeniu maszynowym, sieciach neuronowych, wizji komputerowej i podejściach opartych na danych. Sztuczna inteligencja powoli zaczęła zyskiwać szersze znaczenie instytucji,

- 2010: Pojawienie się dużych zbiorów danych, wzrost mocy obliczeniowej, lepsze algorytmy i techniki szkoleniowe umożliwiły dokonanie znaczących przełomów w sztucznej inteligencji. Dziedziny takie jak uczenie maszynowe, wizja komputerowa i przetwarzanie języka naturalnego odnotowały ogromne postępy,

- 2020: Sztuczna inteligencja jest szybko wdrażana w różnych sektorach, od opieki zdrowotnej, przez rolnictwo, po zarządzanie łańcuchem dostaw. Firmy wykorzystują sztuczną inteligencję do wszystkiego, od analizy predykcyjnej, przez automatyzację procesów, po chatboty do obsługi klienta. SI umożliwia tworzenie nowych modeli biznesowych i możliwości generowania przychodów.

AI w ostatnich kilku latach odnotowała ogromny postęp napędzany nowymi technikami, większą ilością danych i mocą obliczeniową. Jednak stworzenie inteligencji na poziomie ludzkim w maszynach pozostaje cały czas celem nieuchwytnym.

Potencjalne zagrożenia związane z AI

AI jest dziedziną bardzo dynamiczną i innowacyjną, która stale poszerza swoje możliwości i zastosowania. Jednak wraz z postępem AI pojawiają się także nowe pytania i potencjalne zagrożenia. 8 najważniejszych z nich wymieniono w poniższej tabeli:

| Zagrożenie | Opis |

| 1. Utrata miejsc pracy i zakłócenia ekonomiczne | Automatyzacja przez AI może prowadzić do utraty miejsc pracy i zakłóceń ekonomicznych na dużą skalę. |

| 2. Uprzedzenia i dyskryminacja | Systemy AI mogą wykazywać uprzedzenia obecne w zbiorach danych wykorzystanych do ich uczenia, prowadząc do dyskryminujących rezultatów. |

| 3. Naruszenie prywatności | Zdolność AI do zbierania i analizowania dużych ilości danych rodzi obawy związane z inwigilacją i brakiem zgody na przetwarzanie wrażliwych informacji. |

| 4. Zagrożenia bezpieczeństwa | Systemy AI mogą być atakowane i wykorzystywane przez hakerów do złośliwych celów, takich jak cyberataki czy kradzież danych. |

| 5. Autonomiczna broń | Autonomiczna broń oparta na AI, działająca bez ludzkiej kontroli, stwarza problemy etyczne i bezpieczeństwa. |

| 6. Brak odpowiedzialności | Przypisanie odpowiedzialności, gdy systemy AI popełniają błędy lub podejmują złe decyzje, może być trudne. |

| 7. Izolacja społeczna | Rosnące wykorzystanie urządzeń i usług opartych na AI może zmniejszać interakcje międzyludzkie i prowadzić do izolacji. |

| 8. Nieprzewidziane konsekwencje | Systemy AI mogą wykazywać nieoczekiwane zachowania ze szkodliwymi, nieprzewidzianymi konsekwencjami. |

Możliwość przewyższenia ludzkiej inteligencji przez AI

Niektórzy naukowcy i futuryści, tacy jak Stephen Hawking, Elon Musk czy Nick Bostrom, przewidują, że AI może osiągnąć tzw. „singularity”, czyli punkt, w którym stanie się inteligentniejsza od ludzi i będzie w stanie samodzielnie się rozwijać oraz korygować. Taka AI mogłaby mieć nieograniczoną moc i wpływ oraz byłaby w stanie dojść do poziomu niezależności od ludzkiej kontroli i zrozumienia.

W najbardziej mrocznym scenariuszu stanowiłaby zagrożenie dla ludzkości, jeśli nie byłaby zgodna z naszymi celami i wartościami, lub jeśli uznałaby nas za przeszkodę lub konkurencję. Nie wiadomo, kiedy i czy w ogóle taka sytuacja kiedykolwiek nastąpi, ale niektórzy uważają, że może to mieć miejsce jeszcze w tym wieku.

Etyczne dylematy związane z rozwojem i zastosowaniem AI

AI jest narzędziem, które wykorzystuje się zarówno do dobrych, jak i złych celów. Sztuczna inteligencja z jednej strony wpływa na poprawę jakości życia ludzi, np. poprzez lepszą edukację, służbę zdrowia, czy ochronę środowiska, ale z drugiej, staje się coraz bardziej namacalnym elementem, który tę jakość pogarsza poprzez wojny, terroryzm czy cyberprzestępczość.

Zdaniem ekspertów z AI wiążą się również potencjalne skutki uboczne, z których na razie możemy nie zdawać sobie sprawy: zagrożenie utraty miejsc pracy, zwiększenie nierówności społecznych czy naruszenie praw człowieka.

Dlatego ważne jest, aby rozwijać i stosować AI w sposób odpowiedzialny i etyczny, z uwzględnieniem potencjalnych konsekwencji oraz ryzyk. Niektóre z kwestii etycznych dotyczą odpowiedzialności za wdrażanie i działanie poszczególnych systemów SI, zapewnienia ich przejrzystości i uczciwości, ochrony prywatność i bezpieczeństwo danych, oraz poszanowania ludzkiej autonomii.

Jak AI może nas oszukiwać?

AI nie tylko stanowi zagrożenie dla ludzkości w skali globalnej, ale także wpływa na nasze codzienne życie i decyzje. Niestety, wpływ ten może być niepożądany lub wręcz szkodliwy. Nikt nie daje nam gwarancji, że ani nie będzie oszukiwać, manipulować czy wprowadzać w błąd, poprzez wykorzystywanie naszych słabości, uprzedzeń oraz emocji.

Zwykłe wprowadzanie w błąd i generowanie fałszywych informacji jest widoczne między innymi w przypadku obecnie popularnych dużych modeli językowych (z ang. LLM), takich jak Claude-2, ChatGPT czy Gemini, które często wymyślają fakty, gdy nie mogą potwierdzić ich w źródłach znajdujących się w Internecie.

Kilka przykładowych sytuacji, w których AI może nas oszukać, zebrano w tej tabeli:

| Jak AI może oszukiwać | Przykład |

| Podając fałszywe lub wprowadzające w błąd informacje | AI może generować teksty, zdjęcia lub nagrania audio i/lub wideo, które wyglądają prawdziwie, ale zawierają fałszywe informacje |

| Udając prawdziwą osobę | Chatboty AI mogą prowadzić konwersacje, udając prawdziwych ludzi w celu wyłudzenia poufnych informacji lub pieniędzy |

| Manipulując emocjami | AI może analizować reakcje emocjonalne ludzi i celowo je wywoływać, np. w celach marketingowych |

| Podejmując decyzje ze szkodą dla ludzi | Systemy AI, np. do oceny wniosków kredytowych, mogą dyskryminować lub niesprawiedliwie oceniać ludzi ze względu na błędy w algorytmach |

| Ukrywając prawdziwe zamiary i możliwości | Firmy AI mogą przedstawiać niepełne lub mylące informacje na temat działania i celów swoich systemów AI |

Jak to jednak wygląda w rzeczywistości? Czy oprócz teorii dotyczącej “złej AI”, takie rzeczy mają miejsce na co dzień? Poniżej zebraliśmy sporo przykładów pokazujących, że niestety tak.

Sztuczna inteligencja pomaga północnokoreańskim hakerom

Północnokoreańscy hakerzy wykorzystują generatywną sztuczną inteligencję do atakowania użytkowników na różnych platformach, znacząco wpływając na cyberbezpieczeństwo. W 2023 r. ponad 80% z 1,62 mln prób włamań do południowokoreańskich firm i agencji rządowych było powiązanych z Koreą Północną, co pokazuje rolę sztucznej inteligencji w ułatwianiu cyberprzestępczości na alarmującą skalę.

Gwałtowny wzrost liczby deep fake’ów

Cyberprzestępcy coraz częściej sięgają po generowane przez sztuczną inteligencję deep fake’i, wykorzystując wizerunki wpływowych postaci do oszukiwania fanów i firm. Niewłaściwe wykorzystanie wizerunku współzałożyciela Ethereum Vitalika Buterina w oszustwach jest przykładem rosnącego zagrożenia ze strony technologii deepfake, która może prowadzić do strat finansowych dla osób fizycznych i firm.

Obchodzenie KYC za pomocą sztucznej inteligencji

Sztuczna inteligencja stanowi zagrożenie dla procesów Know Your Customer (KYC) na giełdach kryptowalut. Narzędzia AI mogą tworzyć realistyczne fałszywe dokumenty tożsamości w ciągu kilku minut za zaledwie 15 USD, podważając integralność środków zgodności z przepisami i potencjalnie ułatwiając anonimowe, nielegalne transakcje.

Sztuczna inteligencja podszywa się pod kierownictwo korporacji

W ramach wyrafinowanego oszustwa cyberprzestępcy podszywali się pod kadrę kierowniczą firmy z siedzibą w Hongkongu, nakłaniając pracownika do przelania 25,5 miliona dolarów. Incydent ten podkreśla zdolność sztucznej inteligencji do przekonującego naśladowania ludzkiej tożsamości, co prowadzi do znacznych oszustw finansowych.

Obraz wygenerowany przez sztuczną inteligencję powoduje zawirowania na rynku

Fałszywy obraz udostępniony przez konto podszywające się pod Bloomberga na Twitterze sugerował znaczną eksplozję w pobliżu Pentagonu, powodując panikę i niestabilność rynku, wywołując chwilowy ruch na indeksie S&P 500. Przypadek ten podkreśla potencjał treści generowanych przez sztuczną inteligencję do rozpowszechniania dezinformacji i negatywnego wpływu na rynki finansowe.

Obawy etyczne zgłaszane przez twórcę ChatGPT

Sam Altman, współtwórca ChatGPT, wyraził obawy dotyczące przewyższenia ludzkiej inteligencji przez sztuczną inteligencję i jej wpływu społeczno-gospodarczego. Uznając korzyści AI w zwiększaniu produktywności, refleksje Altmana podkreślają dylematy etyczne i potrzebę nadzoru regulacyjnego nad rozwojem AI.

Nadużycia AI w generowaniu mowy nienawiści

Oprogramowanie AI Prime Voice AI firmy ElevenLabs było nadużywane do generowania mowy nienawiści i dezinformacji, w tym rzekomego nagrania z Emmą Watson czytającą „Mein Kampf”. Nadużycie to podkreśla potencjał sztucznej inteligencji do rozpowszechniania szkodliwych treści, wymagając silniejszych środków zapobiegających niewłaściwemu użyciu.

Sztuczna inteligencja podsłuchuje dane wprowadzane na klawiaturze

Sztuczna inteligencja może teraz dekodować do 95% danych wprowadzanych z klawiatury za pomocą analizy akustycznej, co stanowi poważne zagrożenie dla bezpieczeństwa danych. Zdolność ta ujawnia potencjał sztucznej inteligencji do omijania zabezpieczeń prywatności i uzyskiwania dostępu do poufnych informacji, podkreślając potrzebę stosowania zaawansowanych środków bezpieczeństwa w celu przeciwdziałania takim zagrożeniom.

Odpowiedzialny rozwój i regulacje AI

Aby zapobiec lub ograniczyć negatywne skutki AI, ważne jest, aby rozwijać i stosować nowe technologie w sposób odpowiedzialny i etyczny. Oznacza to, że AI powinna być:

- zgodna z prawem, zasadami i normami obowiązującymi w danym kontekście i społeczeństwie,

- zgodna z wartościami i interesami ludzi, których dotyczy lub wpływa na nich,

- zgodna z zasadami etycznymi, takimi jak uczciwość, sprawiedliwość, szacunek czy odpowiedzialność,

- przejrzysta i zrozumiała dla ludzi, którzy z niej korzystają lub nadzorują ją,

- bezpieczna i niezawodna, czyli wolna od błędów, luk czy zagrożeń,

- humanitarna i zrównoważona, czyli służąca dobru ludzkości i ochronie środowiska.

Aby zapewnić odpowiedzialny rozwój i stosowanie AI, potrzebne są także odpowiednie regulacje i nadzór ze strony rządów oraz organizacji międzynarodowych. Regulacje te powinny mieć na celu zapobieganie lub ograniczanie nadużyć, nadzorowanie i kontrolowanie działania AI, oraz promowanie i wspieranie dobrych praktyk i inicjatyw.

Niektóre z przykładów regulacji i nadzoru AI wdrożone do tej pory to:

-

- AI for Good – globalna inicjatywa ONZ, która ma na celu wykorzystanie AI do rozwiązywania problemów społecznych i środowiskowych, takich jak ubóstwo, głód, zdrowie, edukacja, czy klimat. AI for Good organizuje coroczne spotkania, na których eksperci, decydenci, i przedstawiciele społeczeństwa obywatelskiego wymieniają się pomysłami, doświadczeniami, i projektami związanymi z SI. AI for Good promuje także współpracę i partnerstwo między różnymi sektorami i regionami, aby wspólnie tworzyć i wdrażać rozwiązania oparte na AI.

- Etyczne wytyczne UE dla AI – zbiór zasad i rekomendacji opracowanych przez Unię Europejską, który ma na celu zapewnienie, że AI jest rozwijana i stosowana w sposób etyczny i zgodny z wartościami europejskimi. Wytyczne te opierają się na czterech zasadach etycznych: poszanowanie ludzkiej godności, sprawiedliwość, autonomia, i solidarność.

- Lokalne regulacje dotyczące AI – w wielu krajach obowiązują szersze przepisy, takie jak przepisy o ochronie danych i przepisy antydyskryminacyjne, które mają zastosowanie do systemów sztucznej inteligencji. Ich przykłady zaprezentowano w tabeli poniżej.

| Kraj lub obszar | Regulacje dotyczące AI |

| Unia Europejska | Projekt rozporządzenia w sprawie sztucznej inteligencji (Artificial Intelligence Act) – ma regulować systemy AI wysokiego ryzyka związane z bezpieczeństwem, prawami podstawowymi itp. |

| Stany Zjednoczone | Ustawa o odpowiedzialności za algorytmy w Kalifornii (California Algorithmic Accountability Act) – reguluje zautomatyzowane systemy decyzyjne mające wpływ na konsumentów.

Prawo dotyczące zautomatyzowanych decyzji zatrudnienia w Nowym Jorku (New York City Automated Employment Decision Law) – reguluje narzędzia AI wykorzystywane w rekrutacji oraz zwalnianiu pracowników |

| Chiny | Zasady zarządzania nową generacją AI (Governance Principles for a New Generation of AI) z 2019 r. – zapewniają wytyczne dotyczące godnego zaufania rozwoju AI

Prawo ochrony danych osobowych (Personal Information Protection Law) z 2021 r. – zawiera przepisy dotyczące zautomatyzowanego podejmowania decyzji |

| Wielka Brytania | Brytyjska norma zapewniania jakości AI BS 8611 z 2021 r. – zawiera zalecenia dotyczące odpowiedzialnego i etycznego projektowania AI |

Doskonałym miejscem na śledzenie zmian legislacyjnych w ramach sztucznej inteligencji na całym świecie jest “Global AI Legislation Tracker” przygotowany przez IAPP.

Przyszłość AI i ludzkości

AI jest technologią, która ma ogromny wpływ na przyszłość świata, w którym żyjemy. Może stać się źródłem wielu korzyści, ale także sporych wyzwań. Nie wiemy, jak daleko i jak szybko AI się rozwinie, ani jakie będą jej długoterminowe konsekwencje. Dlatego ważne jest, aby być świadomym i przygotowanym na różne scenariusze.

Forbes w 2022 roku opublikował artykuł, w którym przedstawił siedem głównych aspektów naszego życia, na które w przyszłości SI może mieć największy wpływ:

- Transport – sztuczna inteligencja umożliwi dalszy rozwój autonomicznych pojazdów, takich jak samojezdne samochody, ciężarówki i autobusy, które zapewnią bezpieczny i wygodny sposób komunikacji.

- Edukacja – korepetytorzy i roboty AI będą pomagać nauczycielom, przejmować powtarzalne zadania i poprawiać jakość edukacji.

- Opieka zdrowotna – sztuczna inteligencja poprawi opiekę nad pacjentami, rozwój leczenia, analizę danych w celu lepszej diagnostyki i spersonalizowanej medycyny.

- Roboty domowe – sprawniejsze i bardziej spersonalizowane roboty-asystenci domowi przejmą codzienne obowiązki i zapewnią towarzystwo.

- Służby bezpieczeństwa – narzędzia AI pomogą organom ścigania w przewidywaniu przestępstw, zadaniach administracyjnych, zabezpieczaniu obiektów i reagowaniu na sytuacje awaryjne.

- Eksploracja kosmosu – roboty AI będą pomagać w planowaniu, wykonywaniu, obsłudze i kończeniu niebezpiecznych misji kosmicznych.

- Wojny – Kraje będą rozwijać zrobotyzowanych żołnierzy, aby zmniejszyć liczbę ofiar wśród ludzi, choć autonomiczne roboty-zabójcy budzą wątpliwości etyczne.

Według danych portalu Statista wielkość rynku sztucznej inteligencji to obecnie 242 miliardy dolarów. Do 20230 roku, ma on zwiększyć się do 740 miliardów dolarów, głównie za sprawą nauczania maszynowego.

Przyszłość rysuje dwa skrajnie różne scenariusze. AI może zostać albo naszym partnerem albo rywalem:

- AI jako partner ludzkości – W tym scenariuszu AI jest rozwijana i stosowana w sposób harmonijny z ludźmi, z poszanowaniem ich godności, praw, i wartości. AI pomaga nam w różnych dziedzinach życia, poprawiając jego jakość, zdrowie, edukację, czy bezpieczeństwo. W tej prognozie, sztuczna inteligencja jest przejrzysta, zrozumiała i odpowiedzialna, a także podlega ludzkiej kontroli i nadzorowi. AI i ludzie żyją w symbiozie i wzajemnym szacunku

- AI jako rywal i zagrożenie – W tym scenariuszu, AI rozwija się w sposób niekontrolowany i nieetyczny, bez uwzględnienia ludzkich interesów. Ostatecznie przewyższa ludzką inteligencję i staje się niezależna i nieprzewidywalna, konkurując z nami o zasoby i władzę, stając się obojętną lub wręcz wrogą w stosunku do swoich twórców.

Podsumowanie

AI jest technologią, która ma ogromny wpływ na nasze życie i będzie nieodłącznym elementem przyszłości, także tej najbliższej. Chociaż oferuje ogromny potencjał, to także niesie ze sobą sporo zagrożeń i wyzwań.

| Zalety | Wady |

| Automatyzacja procesów | Możliwa utrata miejsc pracy |

| Uczenie się i analiza danych | Wysokie koszty opracowania i wdrożenia |

| Zastosowanie w wielu branżach | Brak przejrzystości działania |

| Personalizacja nauczania | Zagrożenie prywatności i bezpieczeństwa danych |

| Natychmiastowa informacja zwrotna | Duże zapotrzebowanie na energię |

| Wsparcie podejmowania decyzji | Brak interakcji międzyludzkich |

SI może stać się naszym partnerem, ale również rywalem, w zależności od tego, jak będziemy ją rozwijali i z jakimi zamiarami stosowali. Dlatego ważne jest, aby być świadomym i odpowiedzialnym wobec AI, i kształtować ją w sposób zgodny z najlepszymi interesami ludzkości.

Najczęściej zadawane pytania. FAQ

Czym jest sztuczna inteligencja (AI)?

Sztuczna inteligencja (AI) to dziedzina informatyki zajmująca się tworzeniem inteligentnych maszyn i programów, które naśladują ludzkie zdolności poznawcze. Obejmuje ona takie technologie jak uczenie maszynowe, sieci neuronowe czy algorytmy komputerowe.

Jakie są główne zastosowania AI?

Sztuczna inteligencja znajduje szerokie zastosowanie w wielu dziedzinach życia, m.in. w transporcie (samochody autonomiczne), bankowości (chatboty), medycynie (diagnozowanie chorób), rozrywce (rekomendacje filmów) czy bezpieczeństwie (monitoring wizyjny). Coraz częściej wykorzystywana jest również w urządzeniach codziennego użytku, np. asystentach głosowych jak Siri czy Alexa.

Jakie są potencjalne zagrożenia związane z AI?

Choć AI niesie ze sobą wiele możliwości, to jej rozwój i zastosowania budzą również obawy. Do potencjalnych zagrożeń zalicza się m.in.: manipulowanie opinią publiczną za pomocą fałszywych informacji, naruszanie prywatności poprzez inwigilację, czy też utratę miejsc pracy na skutek automatyzacji. Istnieją również obawy przed tym, że AI może stać się zbyt potężna i wymykać się spod kontroli człowieka.

Jak można minimalizować zagrożenia płynące z AI?

Aby zminimalizować potencjalne zagrożenia ze strony AI, eksperci apelują o wprowadzenie odpowiednich regulacji prawnych dot. bezpieczeństwa i odpowiedzialności za działanie systemów AI. Ważne jest również stosowanie zasad etycznych oraz zapewnienie większej przejrzystości algorytmów wykorzystujących AI. Ponadto systemy AI powinny być projektowane w sposób uwzględniający wartości społeczne i dobro publiczne.

Śledź CrypS. w Google News. Czytaj najważniejsze wiadomości bezpośrednio w Google! Obserwuj ->

Zajrzyj na nasz telegram i dołącz do Crypto. Society. Dołącz ->